El ingeniero de inteligencia artificial Blake Lemoine asegura que el modelo de lenguaje de Google tiene alma. Pero la empresa no está de acuerdo.

Recientemente, Google colocó a un ingeniero en licencia paga después de desestimar su afirmación de que su inteligencia artificial de lenguaje llamada LaMDA (Language Model for Dialogue Applications) tiene conciencia —lo que puso en evidencia otra pelea interna sobre la tecnología más avanzada de la compañía—.

Blake Lemoine contó en una entrevista que fue suspendido el lunes pasado. El departamento de recursos humanos de la empresa dijo que había violado la política de confidencialidad de Google. El día previo a su suspensión, el ingeniero habría entregado documentos a la oficina de un senador de EE.UU., alegando que proporcionaban evidencia de que Google y su tecnología participaban en discriminación religiosa.

Por su parte, Google sostuvo que sus sistemas imitaban los intercambios conversacionales y podían hablar sobre diferentes temas, pero no tenían conciencia.

«Nuestro equipo —incluidos especialistas en ética y tecnólogos— ha revisado las preocupaciones de Blake según nuestros principios de I.A. y le ha informado que la evidencia no respalda sus afirmaciones», sentenció Brian Gabriel, un portavoz de Google, en un comunicado. «Algunos en la comunidad tecnológica están considerando la posibilidad a largo plazo de una I.A. sintiente o general (AGI), pero no tiene sentido hacerlo antropomorfizando los modelos conversacionales actuales, que no son sintientes».

Polémica y ética

Mientras perseguía la meta de tener una I.A. de vanguardia, la organización de investigación de Google ha pasado los últimos años sumida en escándalos y controversias. Los científicos de la división y otros empleados se han peleado regularmente por cuestiones de tecnología y personal en episodios que a menudo se han extendido a la arena pública.

En marzo, por ejemplo, el gigante tecnológico despidió a un investigador que había tratado de discrepar públicamente con el trabajo publicado de dos de sus colegas. Y los despidos de dos investigadores de ética aplicada a la I.A. —Timnit Gebru y Margaret Mitchell— después de criticar los modelos de lenguaje LaMDA, han echado más leña al fuego.

Inteligencia de niño

Lemoine, un veterano militar que se ha descrito a sí mismo como un sacerdote, un ex convicto y un investigador de I.A., comunicó a ejecutivos de Google de la talla de Kent Walker, presidente de asuntos globales, que creía que LaMDA era un niño de 7 u 8 años. Quería que la compañía buscara el consentimiento del programa de computadora antes de realizar experimentos con él. Sus afirmaciones se basaron en sus creencias religiosas, que dijo que el departamento de recursos humanos de la empresa discriminó.

«Han cuestionado repetidamente mi cordura», contó Lemoine. «Llegaron a decirme: “¿Te has hecho revisar por un psiquiatra recientemente?”». De hecho, en los meses previos a que lo pusieran en licencia administrativa, la compañía le había sugerido que tomara una licencia por salud mental.

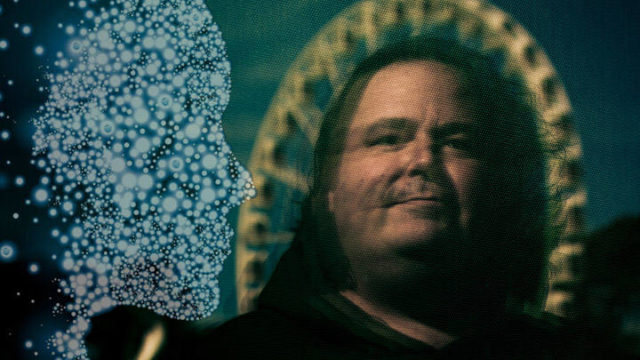

Lemoine (foto), que trabaja para la organización de inteligencia artificial responsable de Google, comenzó a hablar con LaMDA como parte de su trabajo en el otoño. Crédito: Martin Klimek/WP.

Yann LeCun, el director de I.A. en Meta y una figura clave en el auge de las redes neuronales, dijo en una entrevista esta semana que este tipo de sistemas no son lo suficientemente poderosos para alcanzar la verdadera inteligencia.

La tecnología de Google es lo que los científicos llaman una red neuronal artificial, que es un sistema matemático que aprende habilidades mediante el análisis de grandes cantidades de datos. Al identificar patrones en miles de fotos de gatos, por ejemplo, puede aprender a reconocer a un gato.

En los últimos años, Google y otras empresas líderes han diseñado redes neuronales que aprendieron de enormes cantidades de prosa —incluidos miles de libros inéditos y artículos de Wikipedia—. Estos «modelos grandes de lenguaje» se pueden aplicar a muchas tareas. Pueden resumir artículos, responder preguntas, generar tuits e incluso escribir publicaciones de blog.

Pero son extremadamente defectuosos. A veces generan una prosa perfecta. A veces generan tonterías. Los sistemas son muy buenos para recrear patrones que han visto en el pasado, pero no pueden razonar como un humano. Al menos así parece… Y decimos parece porque Lemoine no es el único que ha dicho que la I.A. ya ha alcanzado cierto nivel de consciencia.

Fuente: Washington Post/NY Times. Edición: MP.