A mediados del año pasado, Apple presentó un sistema que consistía en escanear automáticamente el contenido de los usuarios de Fotos de iCloud en busca de material conocido de abuso sexual infantil (CSAM). Si bien la compañía de Cupertino aseguraba que la herramienta había sido diseñada para proteger la privacidad de los usuarios, la iniciativa recibió críticas por doquier, principalmente provenientes de expertos de seguridad y defensores de los derechos digitales.

Estos grupos, por lo general, no cuestionaban el fin legítimo de la herramienta, sino que advertían de que sus capacidades podrían ser utilizadas para incluir otro tipo de contenidos y, por consecuencia, aumentar la vigilancia de los usuarios, socavando su privacidad. Apple, que ya había retrasado el lanzamiento de este sistema de detección, acaba de cancelarlo por completo. En su lugar, ha explicado a The Wall Street Journal, utilizará “otros métodos para proteger a los niños”.

Apple le dice adiós al escaneo CSAM

La decisión de Apple de cancelar completamente su sistema de detección de CSAM llega al tiempo que la compañía anunció tres nuevas herramientas de seguridad que prometen proteger mejor los datos de los usuarios. “El abuso sexual infantil puede evitarse antes de que ocurra”, dijo Craig Federighi. El ese sentido, el máximo responsable de software de Apple dijo que se centrarán en la característica “Seguridad en la comunicación” de Mensajes.

Federighi se refiere a una funcionalidad disponible a partir de iOS 15.2, iPadOS 15.2 y macOS 12.1. En las cuentas configuradas como familia en iCloud se puede activar la seguridad en la comunicación de Mensajes en el apartado Tiempo de uso. El objetivo es evitar que los niños puedan ver imágenes que contienen desnudos. Al recibir este tipo de contenido, la imagen se verá borrosa y se advertirá al niño. Apple dice que esta herramienta mantiene el cifrado de extremo a extremo.

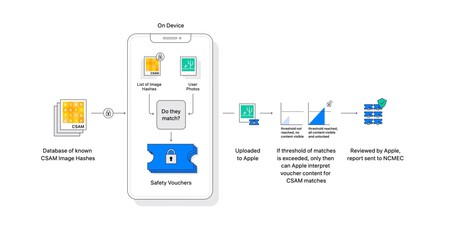

Funcionamiento del sistema de detección de CSAM de Apple.

De acuerdo a WIRED, Apple también está trabajando para expandir la detección de desnudos más allá de las imágenes. La idea es que el sistema sea capaz de detectar contenidos inapropiados también en vídeos, aunque no se ha anunciado una fecha de cuándo los sistemas de la compañía tendrán esa capacidad. Asimismo, la compañía contempla la idea de ofrecer estas herramientas de protección a aplicaciones de mensajería de terceros en el futuro.

Cabe señalar que Apple no ha sido la única tecnológica en contemplar sistemas de escaneo CSAM. Desde hace tiempo que Google tiene su propia herramienta impulsada por coincidencia de hashes e inteligencia artificial para detectar pornografía infantil en imágenes que han sido cargadas en la nube de Fotos. El sistema, pese ser útil para su finalidad y a tener un margen de error mínimo, según la compañía, también puede arrojar falsos positivos.

Imágenes: Apple | Chris Yang | Parker Coffman